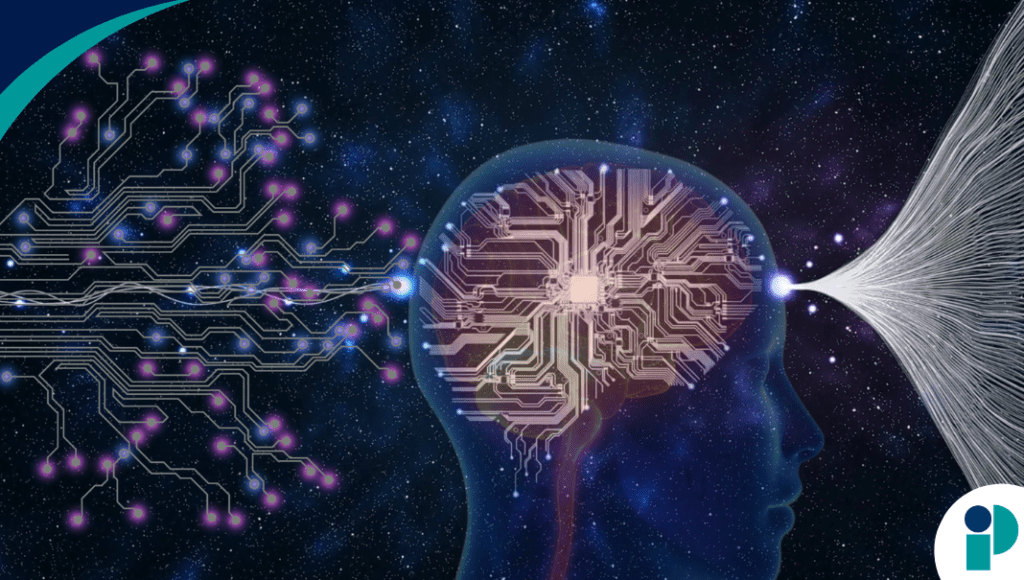

Un nuevo estudio sugiere que el cerebro humano comprende el lenguaje hablado de una manera sorprendentemente parecida a cómo lo hacen los modelos avanzados de inteligencia artificial. Al analizar la actividad cerebral de personas que escuchaban un relato extenso, los investigadores observaron que el significado no aparece de forma instantánea, sino que se construye gradualmente, en capas sucesivas, siguiendo un patrón comparable al procesamiento interno de modelos de lenguaje como GPT o Llama.

La investigación, publicada el 21 de enero de 2026 en Nature Communications, fue liderada por el Dr. Ariel Goldstein, de la Universidad Hebrea de Jerusalén, junto con el Dr. Mariano Schain, de Google Research, y los profesores Uri Hasson y Eric Ham, de la Universidad de Princeton. Los hallazgos desafían las teorías clásicas que conciben la comprensión del lenguaje como un proceso basado principalmente en reglas fijas y estructuras simbólicas.

Para el estudio, los científicos utilizaron registros de electrocorticografía —una técnica que permite medir la actividad eléctrica directamente desde la superficie del cerebro en participantes que escucharon un podcast narrativo de aproximadamente treinta minutos. Este enfoque permitió rastrear con alta precisión cuándo y dónde se activaban distintas regiones cerebrales durante el procesamiento del habla natural.

Los resultados mostraron que el cerebro sigue una secuencia temporal bien organizada. Las respuestas neuronales tempranas se relacionaron con características básicas del lenguaje, mientras que las respuestas posteriores integraron el contexto y el significado más amplio del discurso. Este patrón se alineó notablemente con la arquitectura por capas de los grandes modelos lingüísticos, en los que las primeras capas procesan información elemental y las capas más profundas construyen representaciones semánticas complejas.

La coincidencia fue especialmente marcada en regiones cerebrales asociadas al lenguaje de alto nivel, como el área de Broca. En estas zonas, la actividad alcanzó su punto máximo en etapas tardías del procesamiento, de forma paralela a las capas más profundas de los modelos de IA analizados, como GPT-2 y Llama 2.

“Lo que más nos sorprendió fue la gran similitud entre el desarrollo temporal del significado en el cerebro y la secuencia de transformaciones dentro de los grandes modelos lingüísticos”, señaló Goldstein. “Aunque el cerebro humano y estos sistemas artificiales tienen estructuras muy distintas, ambos parecen converger en un proceso gradual, paso a paso, hacia la comprensión”.

El equipo también evaluó si los componentes lingüísticos tradicionales —como fonemas y morfemas— explicaban adecuadamente la actividad cerebral observada. Sin embargo, estos elementos clásicos resultaron menos predictivos que las representaciones contextuales generadas por los modelos de IA, lo que refuerza la idea de que el cerebro depende más del contexto dinámico que de unidades lingüísticas rígidas.

Según los autores, estos hallazgos no solo ofrecen una nueva perspectiva sobre cómo el cerebro humano construye significado, sino que también posicionan a la inteligencia artificial como una herramienta útil para estudiar la cognición. Lejos de limitarse a generar texto, los modelos de lenguaje podrían ayudar a revelar principios fundamentales sobre cómo emerge la comprensión en sistemas biológicos complejos.

El estudio sugiere, en definitiva, que el significado no está codificado de forma estática en el lenguaje, sino que se va desplegando a lo largo del tiempo, a medida que el cerebro integra información previa y contexto. Una visión que redefine la comprensión del lenguaje y estrecha, de forma inesperada, el vínculo entre la inteligencia humana y la artificial

Fuente: AQUÍ