La incorporación de inteligencia artificial (IA) en dispositivos médicos avanza con rapidez en áreas como cirugía guiada, monitoreo cardíaco e imagenología. Sin embargo, registros regulatorios recientes muestran un incremento en los reportes de fallos de funcionamiento y eventos adversos, lo que ha generado cuestionamientos sobre los mecanismos de evaluación y supervisión de estas tecnologías.

En Estados Unidos, la Administración de Alimentos y Medicamentos (FDA) ha autorizado más de 1.350 dispositivos médicos con componentes de IA, más de la mitad en los últimos tres años. Entre los sistemas bajo revisión se encuentra un dispositivo de navegación quirúrgica utilizado en procedimientos de senos paranasales que incorporó algoritmos de aprendizaje automático para asistir a los cirujanos en la identificación anatómica durante la operación.

Tras la actualización del software, la agencia recibió un aumento en notificaciones relacionadas con mal funcionamiento del sistema. Algunos informes describen desorientación en la localización de instrumentos quirúrgicos y complicaciones graves, incluyendo lesiones vasculares y neurológicas. Las compañías involucradas han señalado que los reportes no establecen una relación causal directa entre la tecnología de IA y los eventos adversos, y que no existen pruebas concluyentes que vinculen el algoritmo con las lesiones reportadas. Los procesos judiciales asociados continúan en curso.

Los reportes de la FDA no están diseñados para determinar responsabilidad individual, sino para identificar posibles señales de seguridad. Además, pueden ser incompletos o incluir múltiples notificaciones por un mismo incidente.

Señales en otros dispositivos y desafíos regulatorios

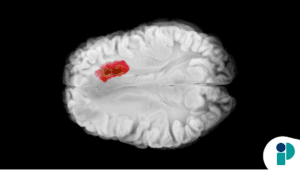

Los sistemas quirúrgicos no son los únicos bajo análisis. Reportes regulatorios también han mencionado software de ultrasonido prenatal que habría etiquetado incorrectamente estructuras fetales, así como monitores cardíacos asistidos por IA que presuntamente no detectaron determinados ritmos anormales. En varios de estos casos no se documentaron lesiones en pacientes, y los fabricantes han indicado que algunos incidentes podrían estar relacionados con factores de uso o visualización de datos.

Investigaciones académicas recientes han identificado que una proporción relevante de dispositivos con IA autorizados por la FDA estuvo vinculada a retiradas del mercado, algunas dentro del primer año posterior a su aprobación. Este hallazgo ha reavivado el debate sobre si los marcos regulatorios tradicionales son suficientes para tecnologías basadas en algoritmos que pueden modificar su desempeño con el tiempo.

A diferencia de los medicamentos, que requieren ensayos clínicos amplios antes de su aprobación, muchos dispositivos médicos ingresan al mercado mediante procesos de equivalencia con tecnologías previamente autorizadas. Especialistas en regulación advierten que este enfoque podría no capturar plenamente los riesgos asociados a sistemas complejos de aprendizaje profundo o modelos adaptativos.

La FDA ha señalado que mantiene estándares rigurosos para dispositivos asistidos por IA y que continúa fortaleciendo su capacidad técnica en el ámbito de la salud digital.

Mientras la inteligencia artificial promete mejorar la precisión diagnóstica, optimizar procedimientos y ampliar el acceso a herramientas médicas avanzadas, los reportes recientes subrayan la necesidad de una vigilancia postcomercialización robusta, transparencia en el desempeño algorítmico y evaluación continua de su impacto en la seguridad del paciente.

Nota original: AQUÍ